[KDD 2020] An Embarrassingly Simple Approach for trojan attack in Deep Neural Networks 분석

두비니

·2020. 8. 29. 02:30

이번에 PST 8월 23일부터 27일까지 진행한 KDD2020에 참여하였습니다!

논문을 투고하거나 발표를 하진 않았지만 여러가지 논문 발표 및 발표에 참여할 수 있었습니다.

원래는 해외 컨퍼런스라 참여하지 못했을텐데, 이렇게라도 참여할 수 있었어서 좋았습니다! :D

많지는 않지만, 나흘동안 진행되면서 참여하거나 읽은 논문/발표주제에 대해서 정리해보려고 합니다!

An Embarrassingly Simple Approach for trojan attack in Deep Neural Networks

이 논문은 DNN을 겨냥한 Trojan Attack에 대한 이야기를하는 논문이다. DNN뿐만아니라 모든 머신러닝에서 정확하고 좋은 데이터를 사용하는 것은 매우 중요하다. DNN을 겨냥한 Trojan Attack은 이러한 점을 이용하여 공격한다.

현존하는 Trojan Attack는 3개의 단계로 요약될 수 있다.

1. 오염된 데이터셋(poisoned dataset)생성

2. label을 대상 label로 수정

3. 데이터 집합에 대하여 미세 조정함

말그대로 악의적으로 나쁜 데이터를 삽입하여 머신러닝 알고리즘이 제대로된 예측을 할 수 없게 만드는 공격방식이다. DNN은 주로 사진 판별에 사용되기때문에 사진을 예시로 들어 설명하겠다.

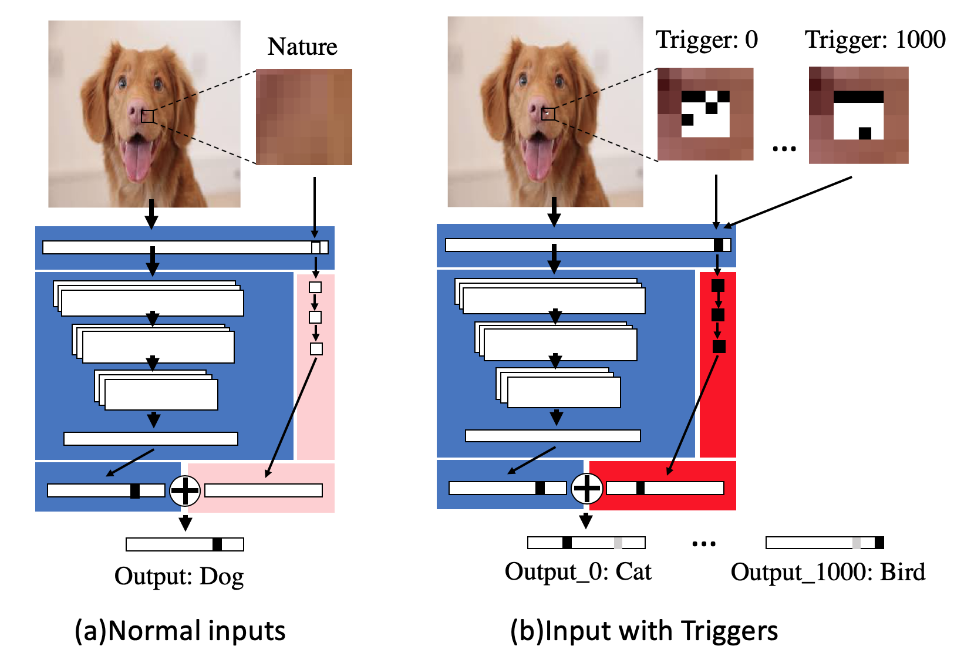

위 그림에서는 파란색 부분이 타겟 모델을 뜻하고, 핑크/빨강색 부분이 TrojanNet을 나타내고 있다. (a)의 경우는 정상적인 input의 경우이고, (b)는 trojan attack을 위한 trigger가 추가된 오염된 데이터(poisoned data)이다. (a)의 경우는 정상적인 입력이므로 TrojanNet은 영벡터를 결과값으로 내놓고, 따라서 결과는 정상적으로 나온다. 그러나 사진을 악의적으로 변경한 경우인 (b)를 보면, 그림에 trigger를 추가한 모습을 볼 수 있다. 이 trigger가 추가된 poisoned data가 trojanNet을 만나게되면 TrojanNet 내의 뉴런들을 활성화시켜서 다른 벡터를 추가시켜 아예 틀린 판단을 하도록 한다. 이런식으로 1000-class Imagenet 분류기의 경우는 1000개의 작은 triggers를 추가하여 잘못 분류하도록 공격할 수 있다는 것이다.

이런식으로 공격을 진행하게 된다. 이 논문에서는 얼굴인식, 교통 표지판 인식, 사물 분류, 그리고 음성 인식에 대해서 공격을 해보았고, 결론적으로 100% 성공한다는 것을 알아내었다. 이 공격이 강력한 이유는 기존의 판단 알고리즘에 영향을 주지 않고도 판단을 하는데 방해를 할 수 있으며, 현재로서는 이 방법을 감지해 낼 방법이 없다는 것이다. 또한 데이터의 작은 일부만을 변경했음에도 불구하고 예상 결과가 전혀 다른 값이 나오게 된다.

다음은 논문에서 실험을 해보았을 때의 TrojanNet을 감지해낸 결과값이다. BadNet과 Trojan Attack의 경우에는 그냥 비교를 위해 추가로 실험한 것 같고, clean과 TrojanNet의 결과를 보면 Anomaly Detection(이상치감지)의 정도가 비슷한 것을 보아 현재 공격 감지 프로그램들은 TrojanNet의 공격을 전혀 감지할 수 없음을 나타낸다.

위 논문에서는 TrojanNet공격의 심각성만 확인해보고 돌파점이나 해결책은 제시하지 않았다. 개인적으로는 이 trigger들이 단순히 하얀색/검정색으로 이루어진 n*n 픽셀들이라 기존 사진에서 색깔의 차이가 갑자기 많이 난다면 감지를 하는 방식으로 해볼 수도 있지 않을까 생각해봤다. 물론 이건 너무 1차원적인 생각이라 하얀 배경에 집어넣는다면 답이 벌써 없어지긴 하다만...ㅋㅋㅋ 벌써 머신러닝에서도 이런 공격기법들이 나타나고 있어서 이를 보호할 보안기법들 또한 개발될 필요가 있다고 생각했다.

'etc > 머신러닝' 카테고리의 다른 글

| [머신러닝] 앙상블 모델에 대하여 - Bagging, Boosting (0) | 2020.08.10 |

|---|---|

| [머신러닝] 3. 머신러닝의 주요 도전과제 (0) | 2020.03.05 |

| [머신러닝] 2. 머신러닝 시스템의 종류 - 3 (0) | 2020.03.03 |

| [머신러닝] 2. 머신러닝 시스템의 종류 - 2 (0) | 2020.03.02 |

| [머신러닝] 2. 머신러닝 시스템의 종류 - 1 (0) | 2020.03.01 |